第2週:複数の変数を使用した線形回帰【Coursera Machine Learningコース】

プログラミング課題の環境構築

- Octaveをインストール

多変量線形回帰 (Multivariate Linear Regression)

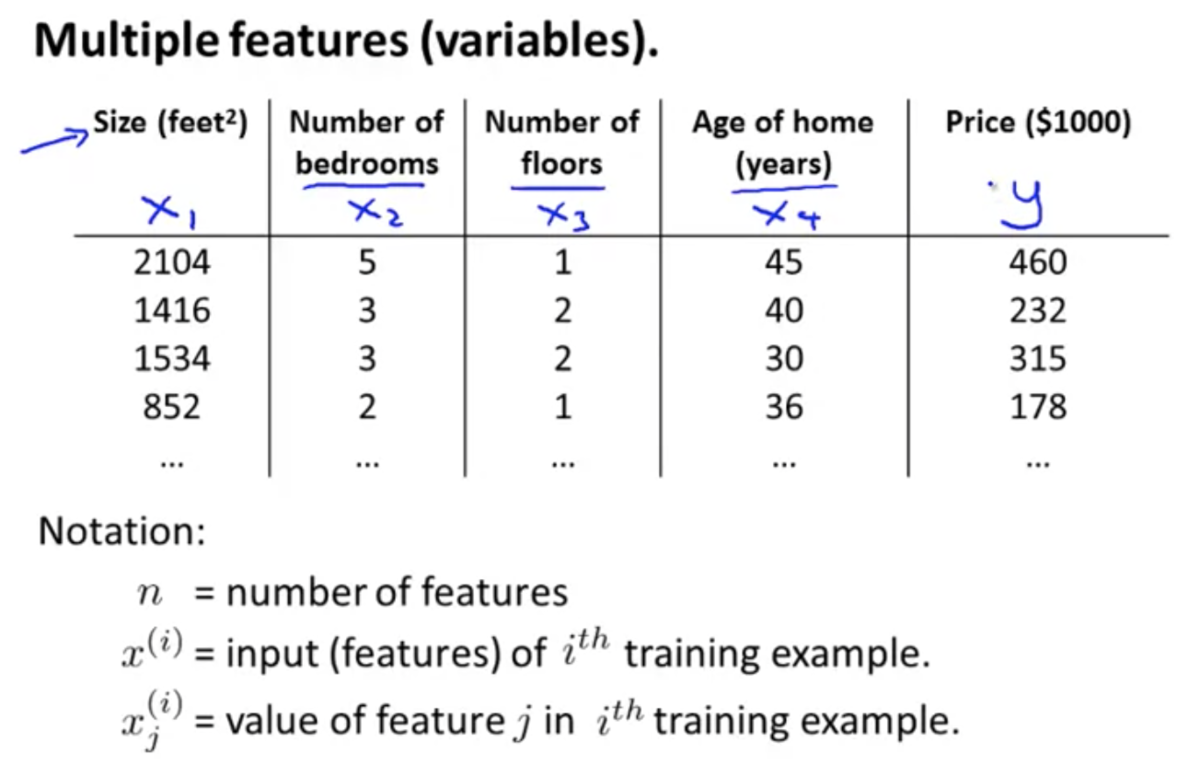

複数の特徴量 (Multiple Features)

複数の特徴量を使う場合を考える

シンボル定義:

のときの仮説関数

:

とおくと、

とかける

→,

はそれぞれn+1次元ベクトルなので、

のようにベクトルの内積としてもかける

このように特徴量が複数ある線形回帰を、多変量線形回帰とも呼ぶ

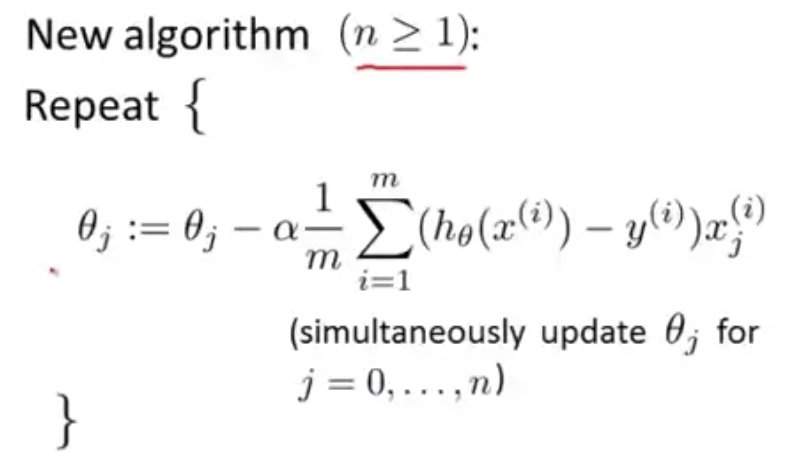

複数の変数の勾配降下

複数の特徴量を持つ仮説関数に対してどのようにパラメータをフィットさせるか?

勾配降下法を多変量線形回帰に適用する場合を考える

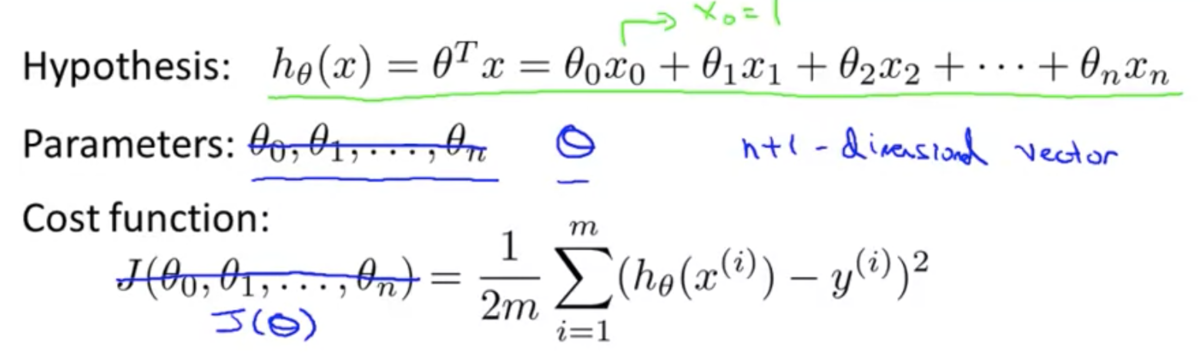

仮説関数、パラメータ、目的関数について:

- パラメータ

はn+1次元ベクトルとして考える

はベクトル

を引数にとる関数として考える

勾配降下法は以下のように一般化される

実践における勾配降下法1 - 特徴量スケーリング

勾配降下法は各特徴量のスケールが似ていると早く収束する

事前に各特徴量に正規化を施してスケールを合わせておくことで、収束までの時間を短縮できる

多くの場合、特徴量が の範囲をとるように正規化する

平均ノーマライゼーション (Mean normalization)

正規化の方法のひとつ

i 番目の特徴量 に対して以下の計算をする (ただし

には適用しない)

: 特徴量

の平均値

: 特徴量

の最大値 - 最小値

実践における勾配降下法2 - 学習率

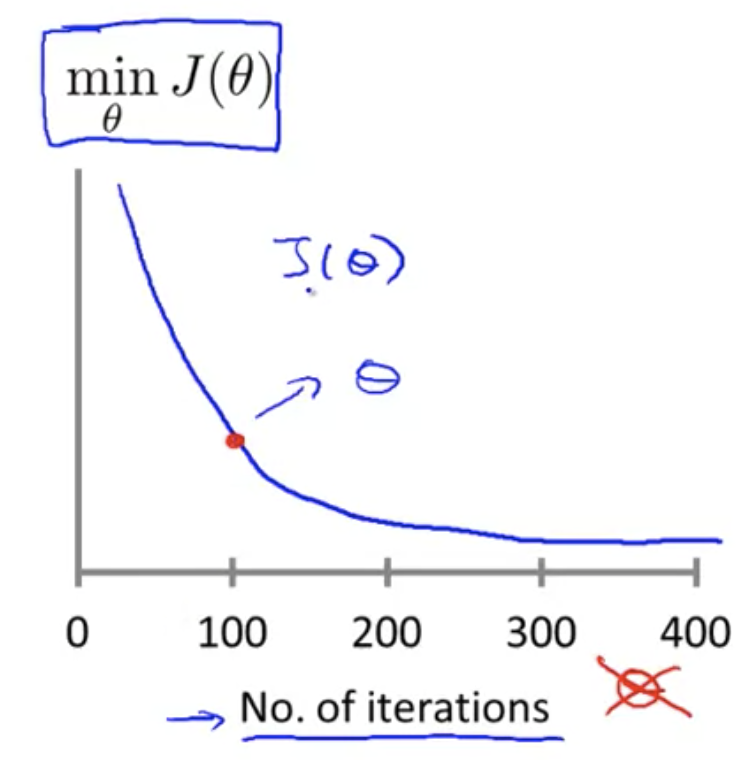

勾配降下法が正しく機能しているか確認する方法

横軸に勾配降下法のイテレーション回数、縦軸に目的関数の値をとって、

の値の推移をプロットする

勾配降下法がちゃんと機能していれば、

の値は減少していく

必要なイテレーション回数を事前に知ることは難しい

そのためこのようにプロットして確認することが必要変化率が小さくなってきたらもう収束しているということ

例えば、一回のイテレーションで

が

しか減少しなかったら収束とみなすことで、自動収束テストも可能 (ただしこの閾値を決めるのもまた難しい)

もし

が増加しているようだったら、オーバーシュートを起こしているのかもしれない

その場合は、学習率を小さくすることで改善できる

(もちろんコーディングミスも疑うべき)- また、

が増減を繰り返すような場合もある

その場合も学習率を小さくすることで改善できる

学習率の選び方

ある程度スケールの異なるいくつかの学習率 で

のプロットを行い、

が順調に減少していそうな学習率を選ぶ

これを何度か繰り返す

特徴量と多項式回帰 (Features and Polynomial Regression)

特徴量の選び方について

例えば住宅価格を予測するために『間口の広さ』と『奥行き』という2つの特徴量を持っているとする

この場合、この2つの特徴量をそのまま使うのではなく、2つの掛け合わせて『敷地面積』というひとつの特徴量を作り出してもいい

多項式回帰について

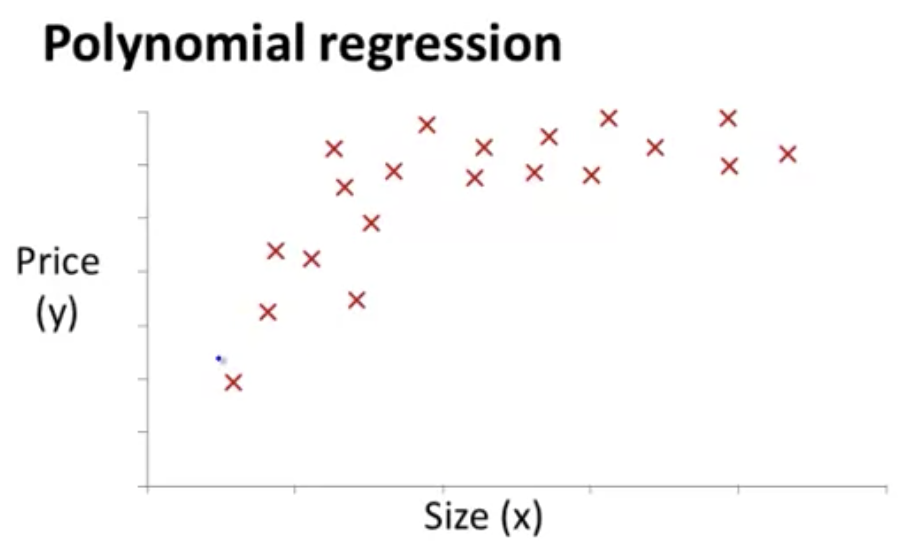

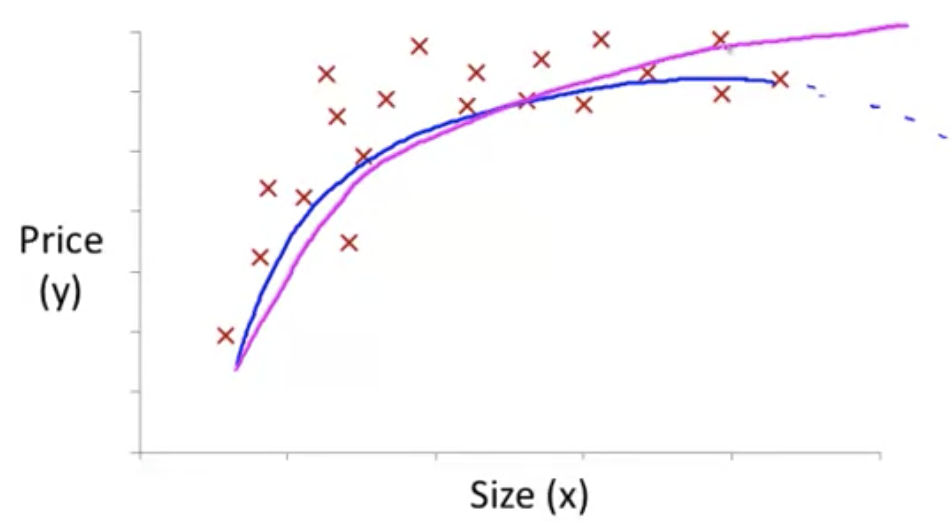

たとえば以下の図のようなデータは、線形回帰だとうまくフィットしなさそうに見える

このような場合、例えば のような二次関数を仮説として使うことができる

ただし、二次関数はいずれ弧を描いて下降するため、住宅価格の予測には適さないかもしれない

代わりに のような関数を選べば降下しなくなる

データのフィッティングの仕方はこれまでと変わらず、

の,

,

をそれぞれ

とおけば、これまで見てきたような

という式として考えることができる

住居の価格としてフィッティングしそうな関数を挙げるとすれば以下のようなもの

パラメータの解析的計算 (Computing Parameters Analytically)

正規方程式 (Normal Equation)

目的関数を最小化する方法として、勾配降下法の他に、正規方程式を解くという方法がある

正規方程式を使ってパラメータを解析的に解くと、一度に全てのパラメータを求めることができる

目的関数を最小化するには

(for every

)

を解けばいい

すると

を得る これが正規方程式

(は逆行列)

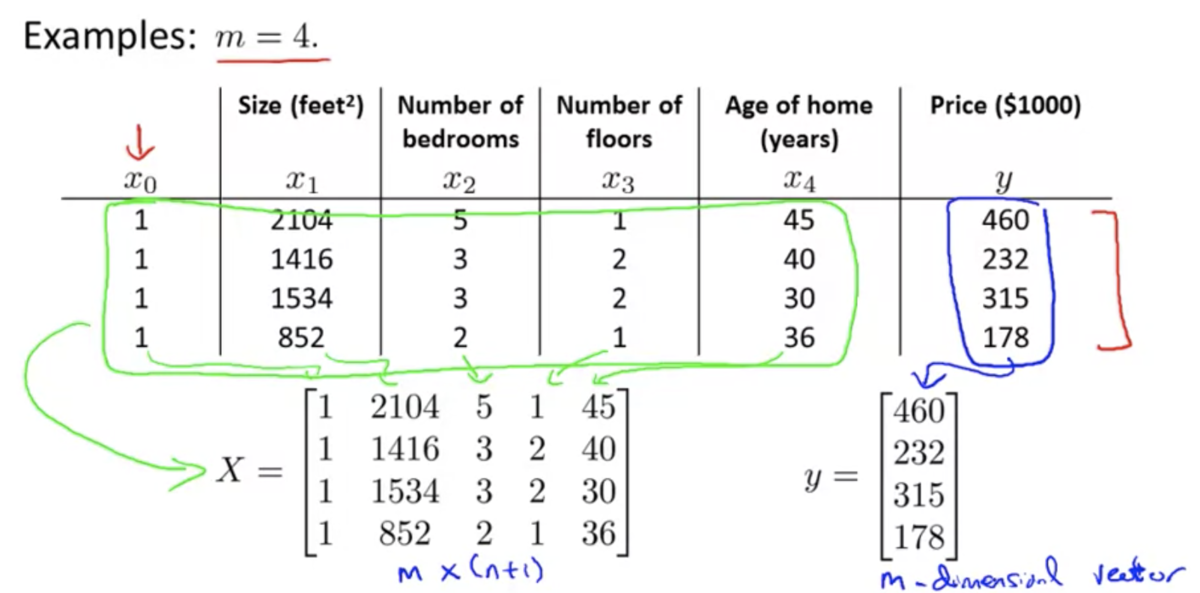

XとYの例

正規方程式を使う場合、特徴量スケーリングは必要ない

正規方程式は、線形回帰では使えるが、より複雑な学習アルゴリズム(ロジスティック回帰など)ではうまく機能しない

勾配降下法と正規方程式のメリット・デメリット

勾配降下法

- メリット

- 特徴量の種類の数が多くても機能する

- デメリット

- 適切な学習率

を試行錯誤して見つける必要がある

- 多くのイテレーションが必要

- 適切な学習率

正規方程式

- メリット

- 学習率

を必要としない

- イテレーションを回す必要がない

- 学習率

- デメリット

- 特徴量の種類の数が多いと計算コストが跳ね上がる

- 逆行列計算の計算オーダーは

らしい

- 経験則として、n = 100 ~ 1000程度なら全然大丈夫、n = 10000くらいになると悩み始めるとのこと

- 逆行列計算の計算オーダーは

- 特徴量の種類の数が多いと計算コストが跳ね上がる

正規方程式の非可逆性 (Normal Equation Noninvertibillity)

補足的な内容らしいのでとばした